OpenAI gym의 CartPole을 DQN과 Double DQN으로 각각 학습한 뒤, 논문의 Figure 3을 graphing하여 비교해봅니다.

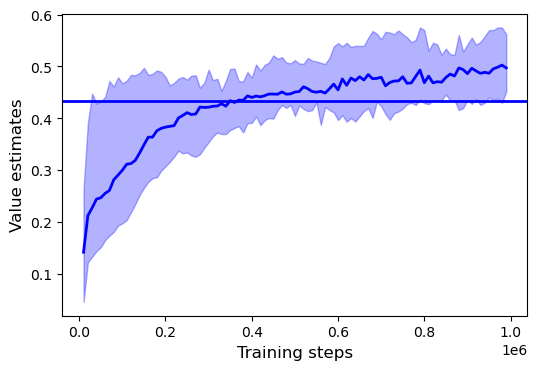

- Double DQN

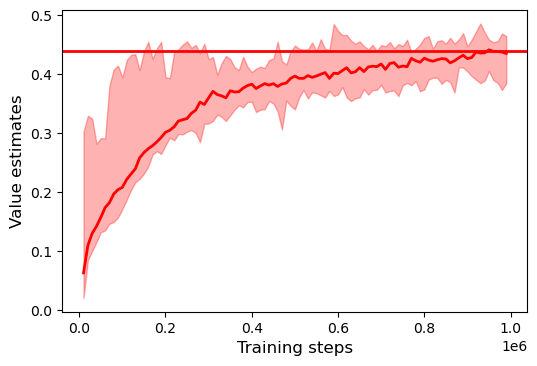

- DQN

-

논문의 결과와 마찬가지로, DQN이 학습 중 overestimation을 일으키는 현상을 관찰할 수 있음.

-

Double DQN의 경우 DQN에 비해 확실히 overestimation의 경향이 적은 것을 볼 수 있음.

-

학습을 마친 후 얻은 average return 값의 경우에도, DQN보다는 Double DQN이 더 높은 값을 보임.

-

학습 중 shaded area의 폭도 Double DQN이 DQN보다 작은 것을 볼 수 있음.

일정 간격 당 에피소드를 gif 파일로 다운로드하려면

rendering = False # True if (n_epi+1)%print_interval==0 else False에서 False를 주석 부분으로 바꿔주면 됩니다. 그러나 렌더링 작업으로 인해 학습 속도가 꽤 느려질 수 있습니다.